2016. Pour acheter, vendre, lire, dire, s’informer, communiquer, le net est partout. Tout indique qu’en 2067, le réseau sera tout aussi présent. Et ses censeurs aussi.

En 2067, nous ne twitterons probablement plus. Pour nous connecter, une puce neurologique ou une interface sensorielle feront office d’écran. Sur les réseaux sociaux, nous ne partagerons plus des photos mais des souvenirs précis, mélange d’images, de sons et d’odeurs.

Difficile, en fait, d’imaginer où en sera la technologie. Mais le réseau, cette super-structure communicationnelle existera. L’information, donc, circulera… Dans les limites qu’on lui impose.

Un réseau au service des entreprises

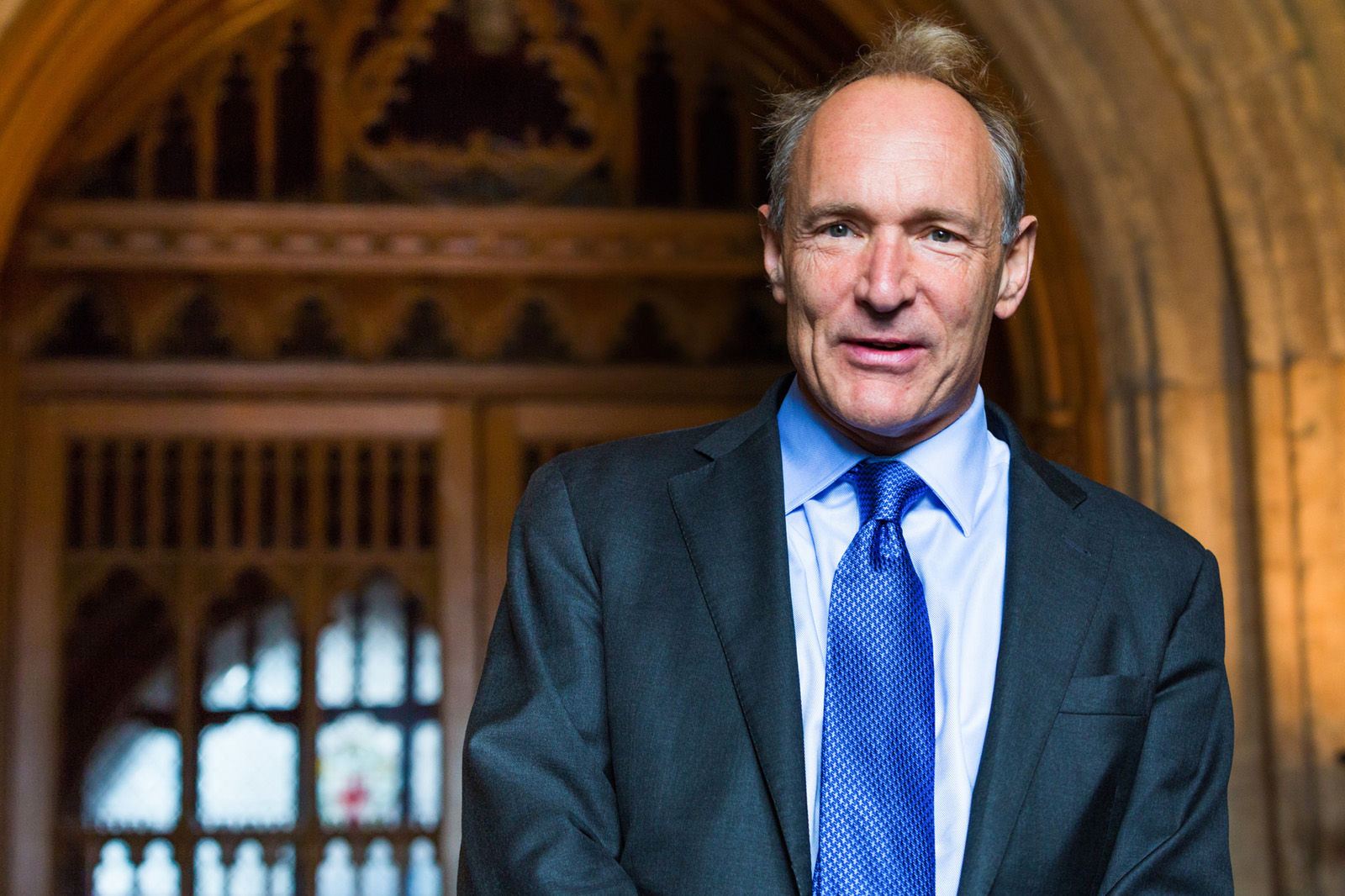

« Le problème du Web réside en la domination d’un seul moteur de recherche, d’un grand réseau social, d’un Twitter pour le microblogging. » Tim Berners-Lee, inventeur du Word Wild Web, le 09/06/2016.

Sur Facebook, déjà, l’information est formatée. Les tétons n’y ont pas leur place. Le nu non plus, même quand il s’agit de l’Origine du Monde, le célèbre tableau de Coubert.

De par la construction de nos réseaux d’amitiés, mais aussi du fait du mode de fonctionnement du premier réseau social mondial, nous sommes de moins en moins confrontés à des avis divergents.

Concrètement, nous voyons les informations de nos proches, souvent du même avis que nous, et celles que nous propose l’algorithme Facebook, calquées sur nos avis et nos centres d’intérêts.

Pour Tim-Berners Lee, créateur du World Wide Web et régulièrement comparé à Albert Einstein pour son apport à la connaissance – rien que ça ! – « le problème du Web réside en la domination d’un seul moteur de recherche, d’un grand réseau social, d’un Twitter pour le microblogging. »

Google, à lui seul, capte 93% des requêtes de recherche en France. Il a théoriquement droit de vie ou de mort sur les contenus qu’il héberge directement. Quant à ceux qui ne lui appartiennent pas… Il lui suffit de ne plus les référencer pour les rendre invisibles au plus grand nombre.

Mais ce phénomène de centralisation est aussi physique. Internet fonctionne sur un modèle client-serveur. Quand un internaute appuie sur une touche, il devient client et formule une demande à un serveur qui mobilise ses données et ses capacités pour lui répondre. L’immense majorité des data centers, ces salles obscures où aucun ordinateur ne s’éteint jamais, sont aujourd’hui la propriété physique des géants du web, Google, Apple, Facebook et Amazon (GAFA).

Le fait que quelques entreprises soient à la fois propriétaires d’internet – l’infrastructure technique – et régulatrices du web – les sites qui s’y greffent – interloque. Ce phénomène de centralisation nuit déjà à la liberté de l’internaute. En 2067, il aura peut-être atteint son paroxysme.

L’impact, sur l’information, serait désastreux et le réseau ne serait structuré que dans le seul intérêt des entreprises qui le détiennent. Les contenus ne faisant pas le jeu de Google ne s’y trouveraient pas; Facebook ne présenterait que des articles allant dans le sens de son entreprise; chacun d’entre eux mettrait en avant ses propres produits pour toujours plus d’hégémonie.

L’hypothèse étatique

« Les politiciens veulent mettre de la politique partout. Ils doivent avoir un rôle, mais rester des partenaires […]. Un modèle avec des décisions centralisées et reposant uniquement sur les gouvernements serait un désastre pour Internet. »

Un exemple ? La Federal Communications Commission, l’équivalent du CSA aux États-Unis, a sanctuarisé la neutralité du web en faisant des opérateurs internet des common carriers.

En clair, ces entreprises sont considérées comme investies d’une mission de service public et sont dans l’obligation de tout mettre en place pour que le plus grand nombre est accès au réseau.

Une bonne intention, qui ne suffit pas à contrebalancer les tentatives incessantes, par des gouvernements, de contrôler internet.

En 2015, 42 pays (contre 37 en 2014) ont demandé à des entreprises ou des privés de supprimer ou de restreindre l’accès à certains contenu. 40 pays ont emprisonné des citoyens pour avoir partagé des contenus sur Internet. Pas besoin de partir loin pour constater que l’État et les institutions judiciaires aiment mettre leur nez dans internet. Il suffit d’aller à Bordeaux, au Tribunal de grande instance, qui a condamné en 2016 plusieurs jeunes rappeurs béglais pour incitation à la haine, suite à la mise en ligne d’un clip de rap.

C’est une exception : dans la plupart des cas, la censure sert surtout l’intérêt des gouvernements. 47 pays en 2015 ont interdit des contenus critiquant le pouvoir en place. 23 ont censuré l’expression d’opposants politiques. 16 ont évité des mobilisations citoyennes.

Bien sûr, tout les pays ne sont pas la Corée du Nord, où les internautes n’ont accès qu’à 28 sites. Mais beaucoup de pays limitent l’accès au web lors de situation « de crise ». C’est le cas en Ethiopie, en Turquie mais aussi en France.

La série de lois misent en place pour lutter contre le terrorisme interdissent, par exemple, la consultation de contenu lié au terrorisme (sauf pour les journalistes et les chercheurs). Le projet de loi sur l’égalité et la citoyenneté est aussi dénoncé une attaque à la liberté de la presse et à la liberté d’expression.

Il durcit la législation sur la presse en ligne et fragilise les dispositifs juridiques protégeant la liberté de la presse. Mais il introduit aussi une liberté d’information à deux vitesses. Adrienne Charmet, de la Quadrature du Net, interrogée par Nextinpact, explique que la loi va privilégier les journalistes et brader « la liberté d’expression de l’ensemble de la population ». D’un côté, les journalistes et les chercheurs jouiraient d’une liberté d’accès à l’information particulière. De l’autre, les citoyens lambda, eux, verraient leurs libertés restreintes sur le web. Le mythe orwellien de Big Brother n’est plus du tout dystopique : en passant par les fournisseurs d’accès à internet, n’importe quel État peut aujourd’hui empêcher à ses citoyens d’accéder à un site web précis.

Sébastien Wesolowski, journaliste à Vice et spécialiste des questions lié au web, résume la situation : « Internet est devenu un outil de rêve pour censeurs, capitalistes et agences de renseignements ».

L’utopie du web décentralisé

L’internet de 2067 sera probablement bien loin de son utopie fondatrice, un réseau libre, accessible à tous et à l’abri de toute censure. Les États ou les entreprises y seront toutes puissantes. Sauf si la résistance, qui s’organise déjà, atteint ses objectifs.

Le 8 et 9 juillet 2017, ils étaient 300 à San Francisco à réfléchir au web de demain. Parmi eux, le fondateur d’internet archive, Brewster Kahle, Mitchell Baker, présidente de la Mozilla Foundation, Vint Cerf et Van Jacobson, co-inventeurs du protocole TCP/IP (la base de tout échange de données sur le web) et Tim-Berners Lee, créateur du World Wide Web.

Pour eux, l’internet de demain doit être un réseau décentralisé pour échapper au modèle client-serveur. Plus de serveur, plus de concentration physique, plus d’hégémonie des Gafa. Des projets concrets voient déjà le jour, comme ZeroNet, lancé en 2014 par l’Hongrois Tamas Kocsis.

Ce nouveau web, qui réduit « la centralisation et la surveillance« , donne « plus de pouvoirs aux utilisateurs« . Ce réseau s’appuie sur la technologie du peer-to-peer, la même que celle utilisée par BitTorrent. Chaque fois qu’un internaute consulte un site, il en héberge une copie sur sa propre machine.

Tous les internautes deviennent à la fois client et serveur, faisant appel, lors de la navigation, aux ressources d’autres particuliers; Exit les serveurs, exit la centralisation. Exit aussi la censure tant qu’un internaute possède au moins une sauvegarde du site visé.

Mais c’est une autre technologique, la blockchain, qui fait vraiment le bonheur des prophètes de la décentralisation. C’est cette technologie de stockage et de transfert de l’information est à la base du bitcoin.

Plus rapide, plus sûr, elle rend complètement obsolète le modèle client-serveur. La clé du système est le block. Chaque interaction – dans le cas du bitcoin, chaque transaction – est consignée dans ce registre. Chaque block est ensuite ajouté à la blockchain, accessible à tous les utilisateurs.

Très technique, cette technologie permet d’assurer la viabilité d’un document, d’échanger en tout sécurité. La blockchain permet aussi de passer outre les acteurs financiers classiques. Incorruptible, ce type de fichier est déjà utilisé pour vérifier la validation des transactions en bitcoin ou certifier des documents officiels. Chaque entrée du registre peut se voir attribuer une empreinte électronique unique – plus besoin de notaire, par exemple. En plus, un État ou une entreprise ne peut rien faire pour censurer ce réseau entièrement décentralisé.

Cette technologie pourrait permettre l’émergence d’un nouveau web. En 2067, tout ne sera pas forcément si sombre.